¡Hola camperos y camperas!

Hoy vengo a hablaros de un tema que está muy relacionado con el White Hat SEO, pero que se sale de la línea general de: crea buen contenido, ten una buena presencia en Internet…

Eso ya está muy escuchado y quería traer a Campamento Web un post de técnicas no tan conocidas o que no se hayan divulgado tanto, como la optimización del archivo robots.txt.

Algunos saben que existen, otros lo oirán por primera vez. Algunos habrán intentado optimizarlo con lo que han encontrado en Internet, otros han muerto desesperados en el intento. Con el artículo de hoy pretendo hacer una guía completa para optimizar este archivo que muchas veces pasa desapercibido cuando hablamos de mejorar el SEO de nuestra página web.

Pero antes de nada, comencemos por el principio.

¿Qué es robots.txt y cómo crearlo adecuadamente?

El archivo robots.txt sirve para indicar a Google qué URLs no quieres indexar o no quieres rastrear. Por ejemplo, porque no son relevantes de cara al usuario o porque tienen muy poco contenido.

¡Meeec, meeec! ¡Google, he rastreado una página nuevaaa!

Lo primero para crearlo es tener un bloc de notas abierto y que se llame «robots.txt». ¡Así de fácil! 🙂

En él comenzaremos a escribir todo lo referente al robots.txt. Siempre comenzaremos con esta línea:

User-agent: *

Esta primera etiqueta le sirve a Google para saber qué robot quieres que rastree tu página. Sus principales robots/rastreadores son Googlebot (para resultados web), Googlebot-Image (exclusivamente para resultados en Google Imágenes) y Googlebot-Mobile (para resultados en móvil). Existen varios más aunque estos a mi juicio son los más importantes. Si queréis conocer todos, podéis visitar esta página de Google.

Sin embargo, en el ejemplo os he puesto el asterisco * porque de esta forma permitimos que todos los robots rastreen nuestra página, ya sea para resultados web, de imágenes o para móviles. Es la forma más común de comenzar robots.txt en cualquier página.

—

A continuación se colocan todos los microformatos, es decir, comenzamos ya a decirle a Google qué queremos que no rastree o indexe.

Vayamos uno por uno.

- Disallow: /

El microformato Disallow hace que Google no se pase por la página que indiquemos y que tampoco la indexe. Podemos aplicarlo de dos formas:

- Si colocamos «/», como en el ejemplo de arriba, se aplicará a todas las URLs. Es decir, ninguna página interna de nuestra web será rastreada ni indexada.

- Podemos indicar que no se rastreen determinadas páginas de la siguiente forma «Disallow: /url-determinada/»

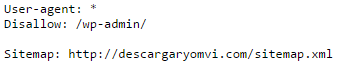

Por ejemplo, si tenemos este robots.txt:

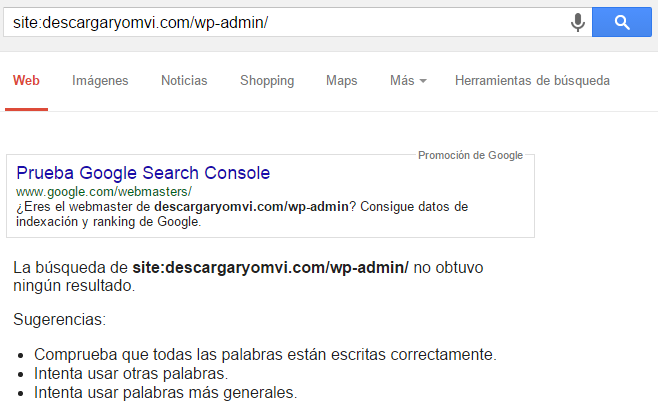

Y luego buscamos la carpeta /wp-admin/ en Google:

No nos dará ningún resultado. ¡Funciona! Ahora puedes tener páginas «secretas» en tu web 😉 .

Otro ejemplo.

Si tenemos esto:

User-agents: *

Disallow: /

Estaremos indicando que todos los robots de Google (User-agents: *) cumplan la orden de no rastrear ni indexar ninguna URL (Disallow: /), por lo que la página completa desaparecería de los resultados de búsqueda. Lógicamente no es algo muy común de ver, pero por si lo necesitáis alguna vez ahí tenéis la forma de hacerlo.

¿Todo entendido por ahora? ¡Pasamos al siguiente microformato!

2. Allow: /receta-de-chocolate/

Este microformato crea una excepción en el Disallow anterior. Imaginemos que nuestra página tiene la siguiente arquitectura web:

- Inicio > Recetas > Receta de chocolate

Por alguna razón, decidimos no indexar la página de «Recetas» con Disallow: /recetas/, pero queremos hacer una excepción porque /recetas/receta-de-chocolate/ sí que queremos que se indexe. Entonces, el robots.txt quedaría así:

User-agents: *

Disallow: /recetas/

Allow: /recetas/receta-de-chocolate/

De esta forma, no se indexará ninguna URL de /recetas/ excepto /receta-de-chocolate/.

3. Sitemap: http://tudominio.com/sitemap.xml

Al igual que es necesario tener un robots.txt, necesitamos tener un sitemap.xml en el que Google pueda rastrear nuestro contenido con facilidad. Se puede crear fácilmente en WordPress con el plugin «XML Sitemap».

Dentro del robots.txt podemos indicar qué sitemap tiene nuestra página tal y como he indicado en el ejemplo.

4. Otros

Tenemos otros microformatos como «noindex» (no indexa la página pero sí rastrea sus enlaces para traspasar autoridad) y «nofollow» (en un principio no tiene en cuenta los enlaces, pero se puede hablar largo y tendido sobre otras hipótesis).

En lugar de colocar estos microformatos en el bloc de notas de robots.txt podemos colocarlo dentro del HTML de la URL interna con el siguiente código:

<meta name=«robots» content=«noindex, nofollow»>

En ese ejemplo, Google no indexaría el contenido ni rastrearía los enlaces.

<meta name=«robots» content=«noindex»>

En este segundo ejemplo, Google no indexaría el contenido (por tanto, no se mostraría en resultados de búsqueda) pero sí rastrearía los enlaces que hay dentro de la página para traspasar autoridad.

<meta name=«robots» content=«nofollow»>

Por último, encontramos este tercer caso en el que la página sí se indexaría pero no se rastrearían los enlaces.

¿Cómo subirlo y ver errores?

Una vez tengamos listo nuestro robots.txt es hora de subirlo para que Google lo tenga en cuenta. Para ello nos vamos a Search Console de Google y seleccionamos nuestro sitio. Si no lo tenemos registrado allí debemos añadir una nueva propiedad con el botón rojo de la esquina derecha.

Una vez vayamos a nuestro sitio vamos a:

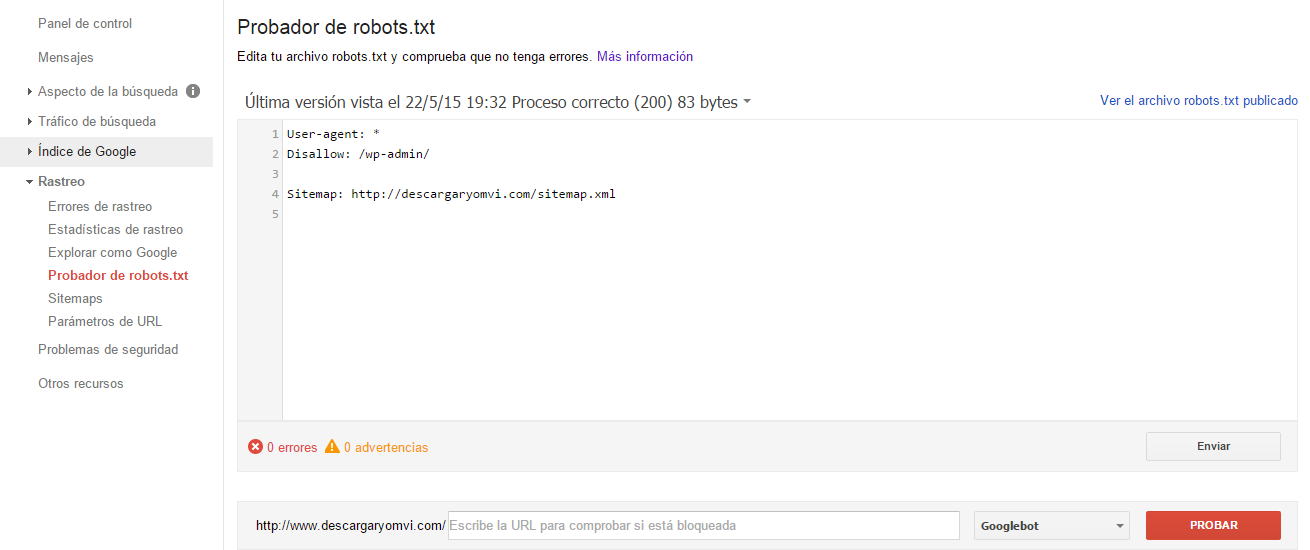

- Rastreo > Probador de robots.txt

Allí podremos subir nuestro bloc de notas o, si ya tenemos un robots.txt subido de antes, editarlo en tiempo real. Lo único que tendrías que hacer es editar el contenido desde la caja de contenido que aparece con el robots actual y darle a «Enviar» para descargarlo.

Abajo encontraremos errores y advertencias, aunque si habéis seguido mis consejos de arriba no deberíais tener ninguno.

Y aquí acaba mi tutorial sobre cómo configurar robots.txt sin morir en el intento 😀 . Espero no haberos liado más y que haya quedado todo claro. Así que ya sabéis, ¡todos a optimizar vuestro robots.txt si no queréis que Google os mire así! 😀

Por mi parte nada más, ¡que tengáis un feliz fin de semana!

Buen post Emilio, hay mucha gente que desconoce totalmente como optimizar el robots.txt y esto le vendrá de perlas. Existen un montón de pequeñas modificaciones que podemos realizar en este documento que nos ayudan de una u otra manera a optimizar nuestro sitio. Recomiendo a todo el mundo investigar un poco más sobre el tema (o que Emilio saque otro post un poco más avanzado ;P).

Un abrazo!

Hola Luis!

Estoy pensando en actualizar este post con información de robots.txt aplicado a eCommerce, que no había caído y es algo más complejo que lo que he explicado. Voy a ponerme manos a la obra en cuanto pueda jaja.

Un abrazoo!

Buenas emilio!!

Es muy interesante todo lo que comentas en el post, pero se puede hacer mucho más fácil desde el plugin «wordpress seo by yoast», justo cuando vas a publicar una entrada, página, producto, o lo que sea, en las opciones de Yoast Seo «Avanzado» puedes poner que no se indexe, además de varias cosas más (como las que comentas) que son muy interesantes 🙂

¡Hola Germán!

Muy buen detalle, no había caído en eso. Gracias por aportar tu granito de arena en el post 😉

Un saludo!

Gracias Emilio. Esto es indispensable hacerlo siempre para cualquier proyecto de blog verdad? 2) con solo descargar el pluggin sitemap no basta? Y wp admin creo q ya viene oculto normalmente en wordpress o no? Una ves mas gracias por el post está todo muy bien explicado.

primero gracias !!! y segundo, existen otras opciones para agregar, que ayuden al seo, o algo que realmente sirva para el posmt!? y tenes algun tuto del archivo .htaccesss

bueno nuevamente gracias !! buen material segui laburando asi!!!